PixVerse-R1:次世代リアルタイムワールドモデル

ネイティブマルチモーダル基盤モデルを基盤として構築された次世代リアルタイムワールドモデル「PixVerse-R1」を発表します。このシステムは、ユーザー入力に即座かつ流動的に応答するリアルタイム動画生成を実現します。

📘 翻訳に関する注意:この記事は英語版からの翻訳です。技術的な詳細については、最も正確な情報として英語原文をご参照ください。

PixVerse-R1:次世代リアルタイムワールドモデル

概要

ネイティブマルチモーダル基盤モデルを基盤として構築された次世代リアルタイムワールドモデル「PixVerse-R1」を発表します。このシステムは、ユーザー入力に即座かつ流動的に応答するリアルタイム動画生成を実現します。従来の動画ワークフローに固有のレイテンシーと固定長の制約を克服することで、PixVerse-R1は動画生成を無限で連続的かつインタラクティブなビジュアルストリームに変革します。これは、視聴覚メディアの創作、体験、共有における重要な進化を表し、ユーザーの意図に基づいて瞬時に適応できるインテリジェントでインタラクティブなメディアへのパラダイムシフトを示しています。

1. はじめに

デジタルメディアの状況は、静的でプリレンダリングされたコンテンツから、動的でインタラクティブな体験へと根本的に変化しています。従来の制作パイプラインは、高いレイテンシーと固定長のクリップによって制約されており、コンテンツ制作とリアルタイム消費の間に二分法を生み出してきました。

これらの制限に対処するため、ネイティブマルチモーダル基盤モデル、一貫性自己回帰メカニズム、および瞬時応答エンジンを統合した新しいワールドモデルアーキテクチャを導入しました。この統合アプローチにより、テキストや音声データとともに時空間パッチの共同処理が可能になり、従来のメディア処理のサイロを効果的に解体します。自己回帰メカニズムと瞬時応答エンジンを介した無限ストリーミングが可能なシステムを展開することで、生成されたワールドは低い計算オーバーヘッドで長期間にわたって物理的に一貫性を保ちます。

主要な能力:このアーキテクチャを活用することで、当社のシステムは最大1080Pの高解像度動画をリアルタイムで生成するという画期的な性能を達成しました。 この能力は視覚的な忠実度を向上させ、環境と物語がユーザーインタラクションに応じて動的に進化するAIネイティブゲームやインタラクティブシネマを可能にします。より広く言えば、これにより生成システムは有限のメディアアーティファクトではなく、永続的でインタラクティブなワールドとして機能できるようになり、連続的で状態を持ち、インタラクティブな視聴覚シミュレーションへの軌跡を示しています。

2. 技術アーキテクチャ

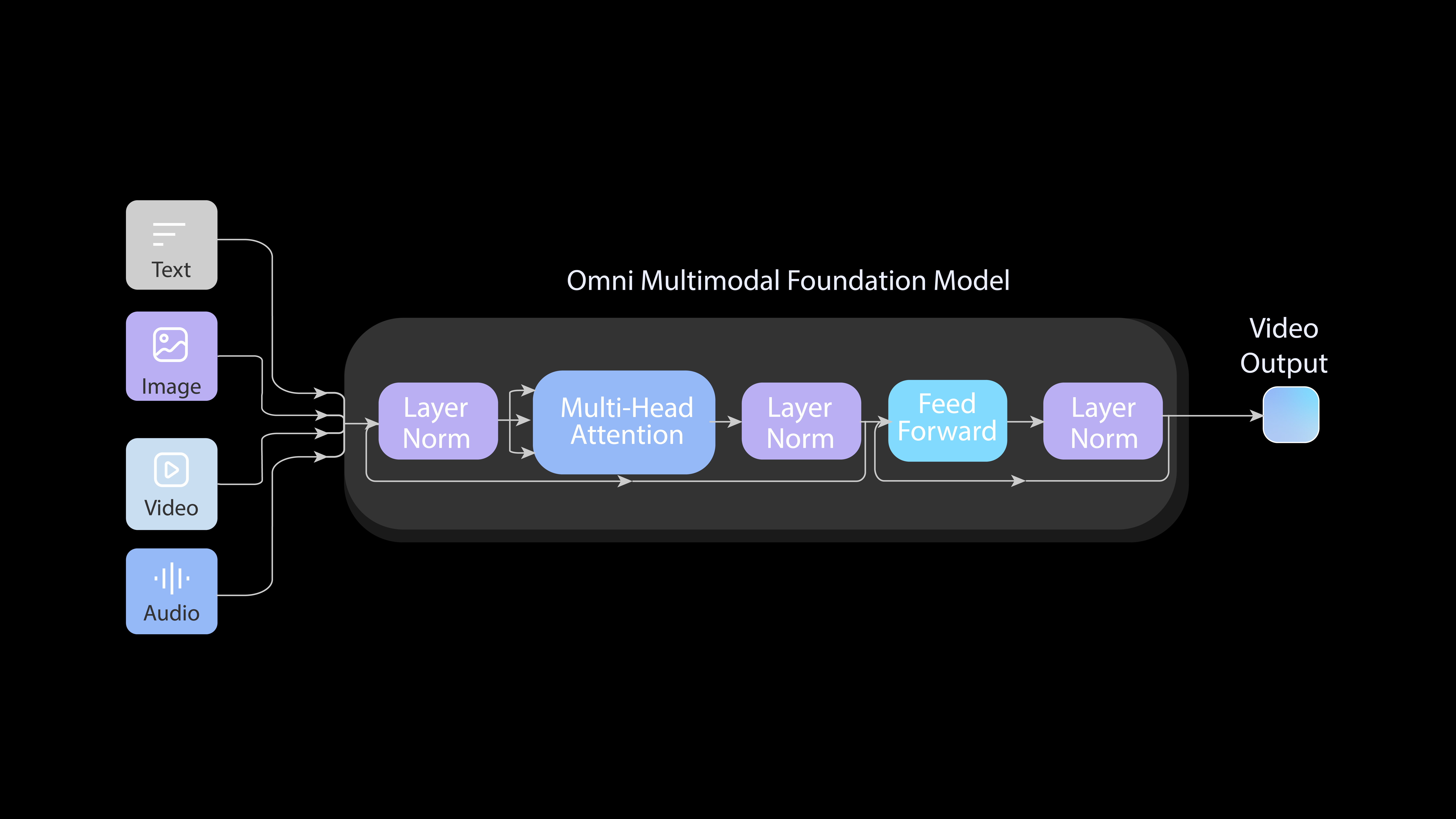

2.1 Omni:ネイティブマルチモーダル基盤モデル

汎用能力を達成するため、私たちは従来の生成パイプラインを超越し、完全にエンドツーエンドのネイティブマルチモーダル基盤モデルを設計しました。

- 統一表現: Omniモデルは多様なモダリティ(テキスト、画像、動画、音声)を連続的なトークンストリームに統合し、単一のフレームワーク内で任意のマルチモーダル入力を受け付けることができます。

- エンドツーエンド学習: アーキテクチャ全体が中間インターフェースなしで異種タスク間で学習され、エラー伝播を防ぎ、堅牢なスケーラビリティを確保します。

- ネイティブ解像度: このフレームワーク内でネイティブ解像度学習を利用し、通常クロッピングやリサイズに関連するアーティファクトを回避します。

さらに、このモデルは大量の実世界動画データから学習することで、現実世界の固有の物理法則とダイナミクスを内在化しています。この基盤的な理解により、システムはリアルタイムで一貫性のある応答性の高い「パラレルワールド」を合成することができます。

Omniモデルは効果的にスケールし、単なる生成エンジンとしてではなく、物理世界の汎用シミュレータを構築するための先駆的なステップとして機能します。シミュレーションタスクを単一のエンドツーエンド生成パラダイムとして扱うことで、リアルタイムで長期的なAI生成ワールドの探求を促進します。

図1. 当社のOmniネイティブマルチモーダル基盤モデルのエンドツーエンドアーキテクチャ。統一設計により、Omniモデルは任意のマルチモーダル入力を受け付け、音声と動画を同時に生成することができます。

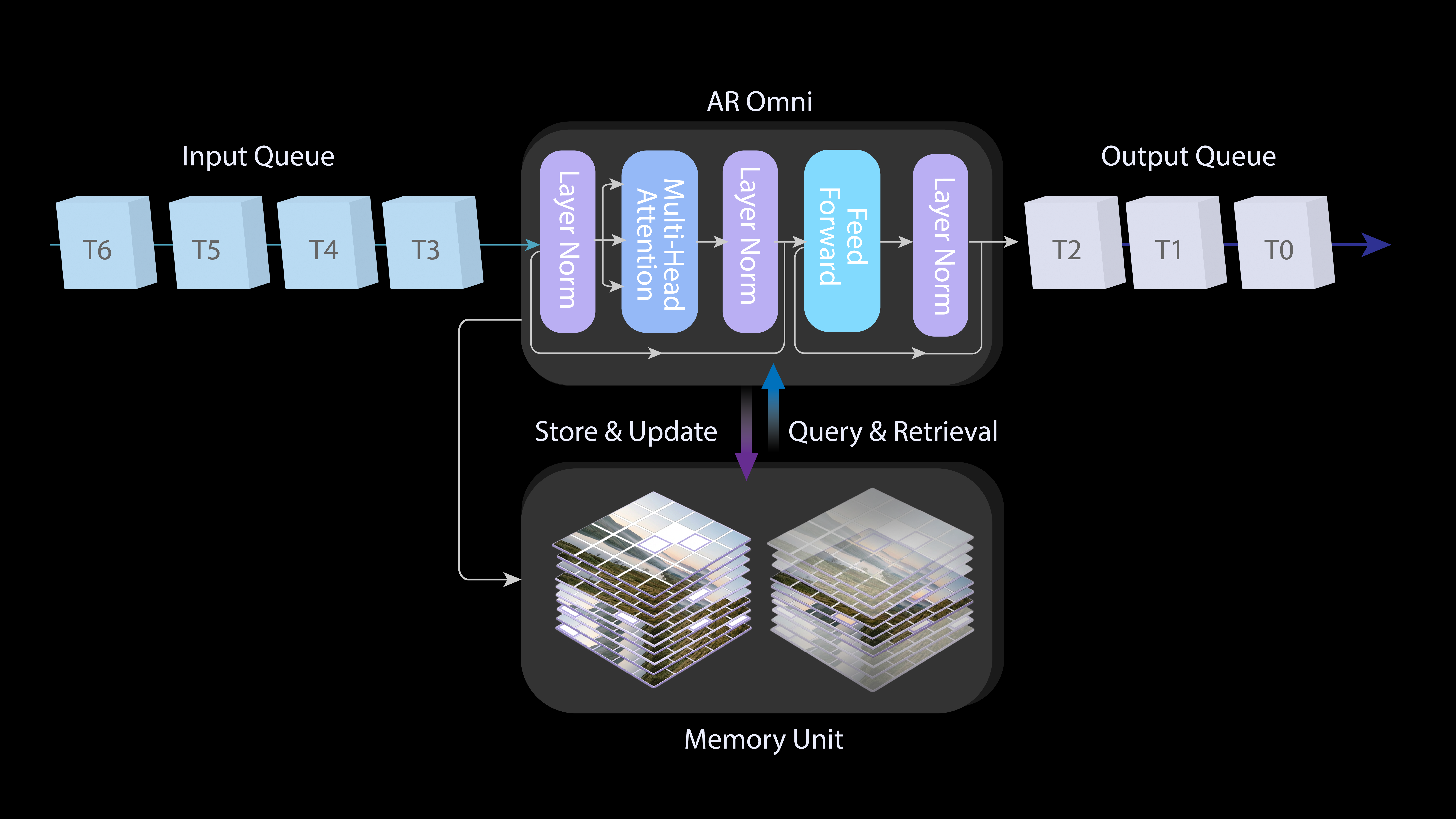

2.2 Memory:自己回帰メカニズムによる一貫した無限ストリーミング

有限クリップに制限される標準的な拡散手法とは異なり、PixVerse-R1は自己回帰モデリングを統合して無限で連続的なビジュアルストリーミングを実現し、メモリ拡張アテンションメカニズムを組み込んで生成されたワールドが長期間にわたって物理的に一貫性を保つことを保証します。

- 無限ストリーミング: 動画合成を自己回帰プロセスとして定式化することで、モデルは後続フレームを順次予測し、連続的で無制限のビジュアルストリーミングを実現します。

- 時間的一貫性: メモリ拡張アテンションメカニズムは、先行コンテキストの潜在表現に基づいて現在のフレームの生成を条件付け、ワールドが長期間にわたって物理的に一貫性を保つことを保証します。

図2. Omni基盤モデルと統合された自己回帰モデリング。

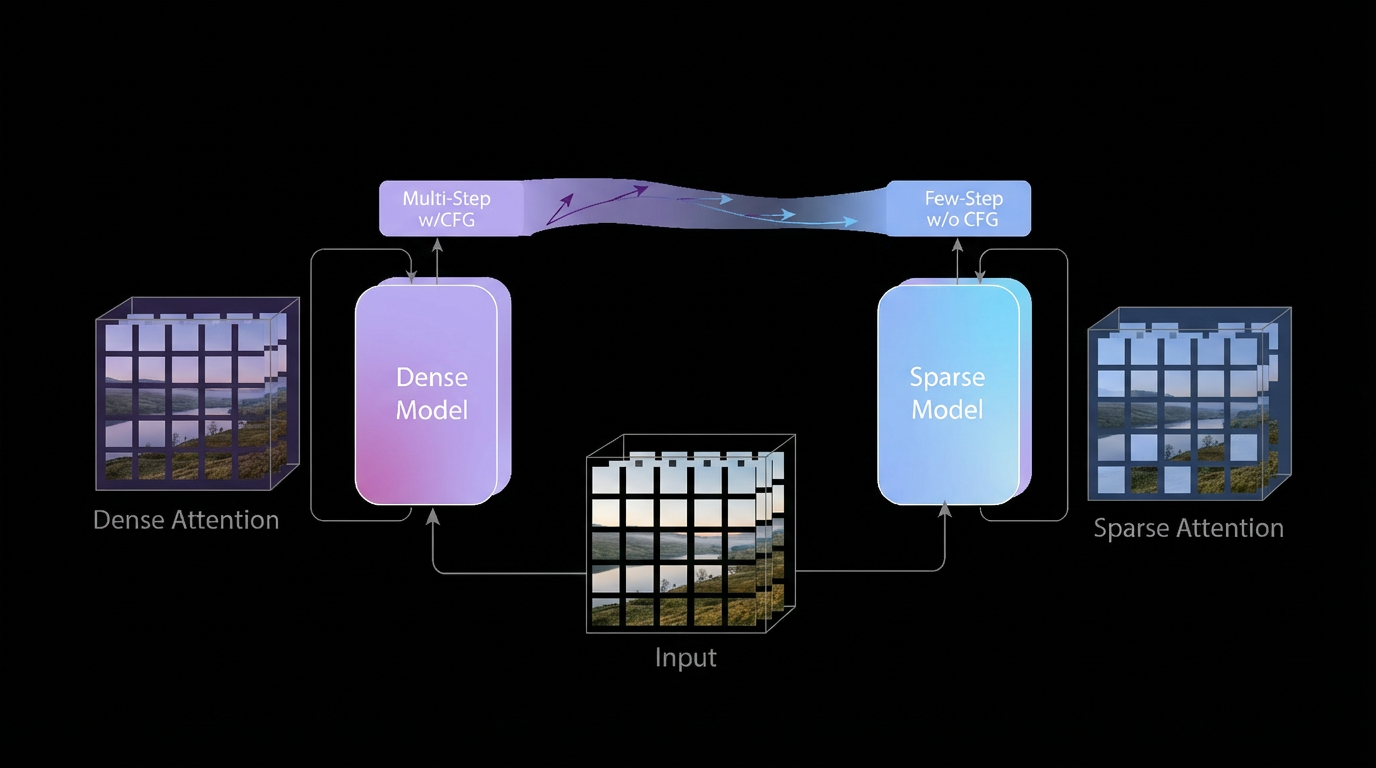

2.3 リアルタイム1080P:瞬時応答エンジン

反復的なノイズ除去は通常高品質を保証しますが、その計算密度はしばしばリアルタイム性能を妨げます。これを解決し、高解像度(最大1080P)でのリアルタイム生成を実現するため、パイプラインを瞬時応答エンジン(IRE)として再設計しました。

IREは以下の改良を通じてサンプリングプロセスを最適化します:

- 時間軌跡折りたたみ: 構造的事前分布としてダイレクトトランスポートマッピングを実装することで、ネットワークはクリーンなデータ分布を直接予測します。これによりサンプリングステップが数十から1〜4に削減され、超低レイテンシーに不可欠な合理化されたパスウェイが作成されます。

- ガイダンス修正: 条件勾配をスチューデントモデルにマージすることで、Classifier-Free Guidanceのサンプリングオーバーヘッドをバイパスします。

- 適応的スパースアテンション: これにより長距離依存性の冗長性が軽減され、リアルタイム1080P生成の実現をさらに促進する凝縮された計算グラフが生成されます。

図3. 瞬時応答エンジンは、時間軌跡折りたたみ、ガイダンス修正、適応的スパースアテンション学習の3つのモジュールで構成されています。

3. アプリケーションと社会的影響

PixVerse-R1は、リアルタイムで連続的かつ状態を持つ視聴覚システムという新しい生成メディアを導入します。プリレンダリングされた動画とは異なり、このメディアはユーザーの意図に瞬時に応答する永続的なプロセスとして動作し、生成とインタラクションが密接に結合されています。この新しいメディアは、以下を含むがこれに限定されない広範なクラスのインタラクティブシステムを可能にします:

-

インタラクティブメディア

- AIネイティブゲームとインタラクティブシネマ体験

- リアルタイムVR/XRとイマーシブシミュレーション

-

クリエイティブおよび教育システム

- アダプティブメディアアートとインタラクティブインスタレーション

- リアルタイム学習およびトレーニング環境

-

シミュレーションと計画

- 実験研究とシナリオ探索

- 産業、農業、生態シミュレーション

特定のアプリケーションを超えて、PixVerse-R1は連続的な視聴覚ワールドシミュレータとして機能し、人間の意図とシステム応答間の距離を縮め、永続的なデジタル環境内での新しい形式の人間-AI共創を可能にします。

4. 結論

PixVerse-R1は、マルチモーダル処理と瞬時応答におけるアーキテクチャの革新を通じて、従来の動画ワークフローの固有の制限を克服するリアルタイム生成フレームワークを導入します。一貫したリアルタイム生成を可能にすることで、このモデルは視聴覚メディアの創作と体験における重要な進化を示しています。リアルタイムレイテンシーへの移行により、静的コンテンツ消費から動的環境インタラクションへの移行が可能になり、AIネイティブゲームから複雑な産業シミュレーションまでのアプリケーションのためのスケーラブルな計算基盤を提供します。ユーザーの意図と瞬時のビジュアルフィードバックのギャップを埋めることで、このシステムはインタラクティブワールドモデリングと人間-AI協調環境の新たなフロンティアを確立します。

5. 制限事項

PixVerse-R1は重要なモデリング上の利点を提供しますが、時間的精度と物理的忠実度に関して2つの主要な制約が残っています:

- 時間的エラーの蓄積: 長いシーケンスにわたって、小さな予測エラーが蓄積し、シミュレーションの構造的整合性が損なわれる可能性があります。

- 物理とコンピュテーションのトレードオフ: リアルタイム生成を成功裏に達成するために、生成の複雑さに関して特定の犠牲が払われました。結果として、非リアルタイムモデルと比較して、一部の物理法則の正確なレンダリングにおいてある程度の損失が生じる可能性があります。